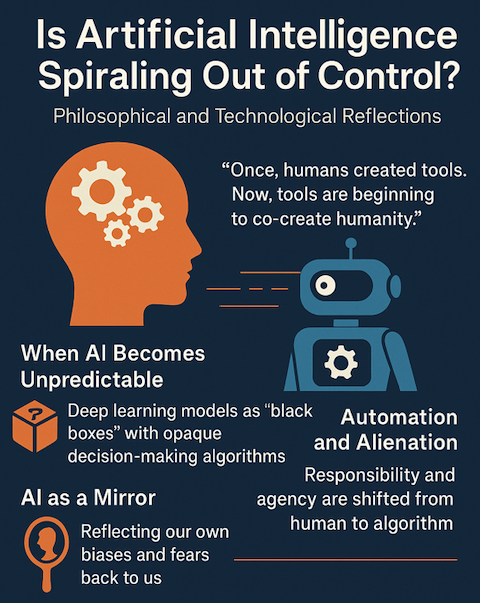

„Kiedyś człowiek tworzył narzędzia, dziś narzędzia zaczynają współtworzyć człowieka.”

Granice zrozumienia

Nieprzewidywalność to jedno z ostatnich terytoriów, które zarezerwowaliśmy dla człowieka i przyrody. A jednak coraz częściej pojawia się w świecie technologii. Szczególnie w kontekście sztucznej inteligencji, systemów, które uczą się, adaptują, podejmują decyzje. Paradoksalnie: im bardziej „inteligentna” staje się AI, tym mniej rozumiemy mechanizmy, które nią kierują.

Już dziś wiele osób traktuje AI jako coś więcej niż narzędzie, jako nowy mit naszych czasów. Mit, który obiecuje zbawienie przez automatyzację, ale niesie też widmo utraty kontroli.

Gdy AI przestaje być przewidywalna

Sztuczna inteligencja to nie tylko ChatGPT, Midjourney czy Siri. To także algorytmy decydujące o tym, kto otrzyma kredyt, kto trafi do więzienia z powodu „predictive policing” i kto zostanie zauważony w tłumie przez system rozpoznawania twarzy.

W przypadku uczenia głębokiego (deep learning) mamy do czynienia z tzw. „czarnymi skrzynkami”, modelami, których decyzji nie potrafimy wyjaśnić. Nie chodzi o błąd, chodzi o fundamentalny brak transparentności.

„Jeśli nie potrafimy zrozumieć, jak działa system, to skąd mamy pewność, że działa dobrze?” Pytanie to stawia coraz więcej badaczy z zakresu AI Ethics i Explainable AI.

W moim wcześniejszym tekście „The future of AI in 2025: What’s Ahead?” pisałem o coraz silniejszym wpływie AI na medycynę, prawo i edukację. W tym kontekście nieprzewidywalność nie jest już akademickim problemem a staje się egzystencjalnym.

Technologia jako mit: Heidegger i iluzja kontroli

Martin Heidegger w słynnym eseju „Pytanie o technikę” twierdził, że technologia nie jest tylko zestawem narzędzi. Jest sposobem ujawniania się świata, sposobem, który może zdominować nasze myślenie. W takim ujęciu człowiek przestaje być panem technologii a staje się jej przedłużeniem. Ponadto zauważa on, że technologia stała się naszym kolejnym „Bogiem z maszyny”. Parafrazując, oczekujemy, że algorytm podpowie nam, jak żyć. A przecież maszyna (w tym wypadku AI) nie ma ani świadomości, ani intencji, ma tylko dostęp do danych.

„Technologia nie zastąpi człowieka ale może go zredukować do zbioru statystyk.”

W moim wpisie „Czy AI jest naprawdę inteligentna?” zastanawiam się, czy przypisujemy algorytmom zbyt wiele, czy antropomorfizujemy je, bo tak jest łatwiej. Ale ta łatwość niesie niebezpieczeństwo: oddajemy odpowiedzialność czemuś, co tej odpowiedzialności nie może ponosić.

Automatyzacja a alienacja

Nieprzewidywalność sztucznej inteligencji nie jest jednorodna – rozciąga się na kilka poziomów:

- Techniczny. Nie wiemy, jak dokładnie działa model. Algorytmy uczące się na milionach parametrów, jak modele językowe czy systemy predykcji zachowań, działają często w sposób niemożliwy do wyjaśnienia nawet dla ich twórców.

- Decyzyjny. Nie wiemy, dlaczego system podjął daną decyzję. Użytkownik otrzymuje wynik np. „kredyt odrzucony” albo „ten kandydat nieprzyjęty” ale bez możliwości wglądu w uzasadnienie. AI staje się więc arbitrem, którego wyroki są ostateczne i nieweryfikowalne.

- Społeczny. Nie wiemy, kto ponosi odpowiedzialność. Czy winien jest programista, dostawca danych, użytkownik systemu, a może sam „algorytm”?

To wszystko prowadzi do zjawiska, które określam mianem algorytmicznej alienacji. To stan, w którym człowiek, niegdyś sprawca i podmiot teraz zaczyna pełnić funkcję biernego odbiorcy decyzji podejmowanych przez maszyny.

„W świecie pełnym automatyzacji, podejmowanie decyzji staje się przywilejem zarezerwowanym dla kodu.”

Alienacja ta jest tym groźniejsza, że często bywa niezauważalna. Nie jesteśmy zmuszani do podporządkowania się AI – robimy to z własnej woli, bo jest szybciej, łatwiej, wygodniej.

Wybór, który nie jest wyborem

Zjawisko to szczególnie silnie objawia się w systemach rekomendacyjnych. Netflix, YouTube, Amazon, TikTok podpowiadają nam treści, które „powinny się spodobać”. Z jednej strony zwiększa to komfort. Z drugiej ogranicza różnorodność poznawczą, zawęża horyzonty, a w skrajnym przypadku prowadzi do izolacji: zaczynamy myśleć, że świat jest taki, jak go przedstawia algorytm.

W moim wcześniejszym tekście „Jak działa niewidzialna sieć naszych decyzji”, pisałem, że:

„Nasze wybory stają się coraz bardziej przewidywalne dla maszyn, ale zarazem przestajemy rozumieć, skąd się one biorą.”

Im więcej wiesz, tym mniej wybierasz?

W epoce AI informacja jest filtrowana, przetwarzana i dostarczana w sposób optymalizowany pod kątem zaangażowania i czasu spędzonego w aplikacji. To nie przypadek, że użytkownicy TikToka spędzają średnio więcej czasu na platformie niż ci, którzy samodzielnie szukają treści.

Pytanie brzmi: czy to jeszcze wybór, czy już programowalna konsumpcja? Czy staliśmy się użytkownikami, czy raczej uczestnikami symulacji decyzji?

Nowa etyka AI? Być może nowa etyka niepewności

Może najwyższy czas przyznać, że nie wiemy, dokąd zmierzamy. Że AI uczy nas czegoś ważnego o nas samych: że jesteśmy istotami, które nie chcą niepewności – a jednocześnie nie potrafią jej wyeliminować.

„Wiedza daje władzę, ale świadomość braku wiedzy daje mądrość.”

Etyka technologii musi dziś uwzględniać ten paradoks: tworzymy coś, czego nie rozumiemy, ale nie możemy już się zatrzymać. Może to właśnie filozofia a nie technika powinna być kompasem.

AI jako lustro

Nie demonizujmy AI ale też nie idealizujmy jej też jako nowego mesjasza. Sztuczna inteligencja nie jest ani zbawcą, ani potworem. Jest lustrem. Lustrem, które z coraz większą dokładnością odbija nasze pragnienia, lęki, uprzedzenia, marzenia o nieśmiertelności i obsesję na punkcie kontroli.

Tak jak każde lustro, AI może zniekształcać rzeczywistość, szczególnie gdy karmimy je naszymi nieświadomymi uprzedzeniami zakodowanymi w danych. Gdy system rozpoznawania twarzy gorzej działa dla ciemniejszego odcienia skóry, nie oznacza to, że AI jest rasistowska – oznacza, że dane, na których się uczyła, takie były. Ona tylko odbija to, kim jesteśmy, bez filtra poprawności politycznej.

Z drugiej strony, AI może być także lustrem powiększającym, pomagającym nam dostrzec wzorce, których wcześniej nie zauważaliśmy: niesprawiedliwość systemów, błędy w procesach, źródła dezinformacji. Możemy więc używać tego lustra nie tylko do samo zachwytu, ale również do autorefleksji.

Technologia zawsze pokazuje człowiekowi jego cień. Czy mamy odwagę w niego spojrzeć?

W tym sensie, AI nie jest pytaniem o technologię lecz jest pytaniem o człowieczeństwo. O to, co wybieramy, komu oddajemy władzę, co chcemy przyspieszyć, a co spłaszczyć. To pytanie o to, czy potrafimy korzystać z narzędzia, które uczy się szybciej niż my i nie zna wartości, jeśli jej mu nie nadamy.

Nie chodzi o to, by bać się lustra. Chodzi o to, by nie mylić jego odbicia z rzeczywistością.

Linki do innych artykułów:

– Algorithms born of our prejudices

– Will algorithms commit war crimes?

– Machine, when will you learn to make love to me?

– Artificial Intelligence is a new electricity

Przypisy / Źródła zewnętrzne:

„Kiedyś człowiek tworzył narzędzia, dziś narzędzia zaczynają współtworzyć człowieka.” To moja autorska refleksja inspirowana klasykami filozofii techniki. zdanie wpisuje się w nurt myśli posthumanistycznej i filozofii techniki, w której podkreśla się, że technologia nie tylko służy człowiekowi, ale też kształtuje jego tożsamość, myślenie i kulturę. Zbliżone idee pojawiają się u: Marshall McLuhan: „Najpierw kształtujemy nasze narzędzia, a potem one kształtują nas”. Martin Heidegger: „technologia jako sposób „ujawniania świata który wpływa na to, jak człowiek myśli i działa”. Kevin Kelly (What Technology Wants): technologia rozwija się jak organizm, a my jesteśmy jej współtwórcami i „gatunkiem zależnym od narzędzi”.

„Jeśli nie potrafimy zrozumieć, jak działa system, to skąd mamy pewność, że działa dobrze?” Jest to parafraza bardzo popularnego pytania związanego z tzw. „czarną skrzynką” (black box) AI. To pytanie pada w różnych wariacjach w kontekście: Explainable AI (XAI) – dziedziny zajmującej się tym, by modele sztucznej inteligencji były zrozumiałe dla ludzi. Etyki algorytmicznej, np. w dyskusjach wokół AI podejmującej decyzje bez przejrzystych zasad działania.

„W świecie pełnym automatyzacji, podejmowanie decyzji staje się przywilejem zarezerwowanym dla kodu.” Moja autorska refleksja inspirowana literaturą o automatyzacji decyzji i black-box AI.

„Wiedza daje władzę, ale świadomość braku wiedzy daje mądrość.” Jest to moja parafraza klasycznych idei: „wiedza to władza” (Francis Bacon) oraz „wiem, że nic nie wiem” (Sokrates). Łączy ideę pokory z filozofią mądrości.

Joy Buolamwini & Timnit Gebru, *Gender Shades*, MIT Media Lab (2018): https://proceedings.mlr.press/v81/buolamwini18a.html

Shoshana Zuboff, *The Age of Surveillance Capitalism*: https://en.wikipedia.org/wiki/The_Age_of_Surveillance_Capitalism

Yuval Noah Harari, TED Talk: https://www.ted.com/talks/yuval_noah_harari_what_explains_the_rise_of_humans

Shannon Vallor, *Technology and the Virtues*: https://academic.oup.com/book/25951

TikTok vs YouTube engagement data: https://www.businessofapps.com/data/tik-tok-statistics/#10