Mój artykuł wSpiders’Web z dnia 19 luty 2019 roku.

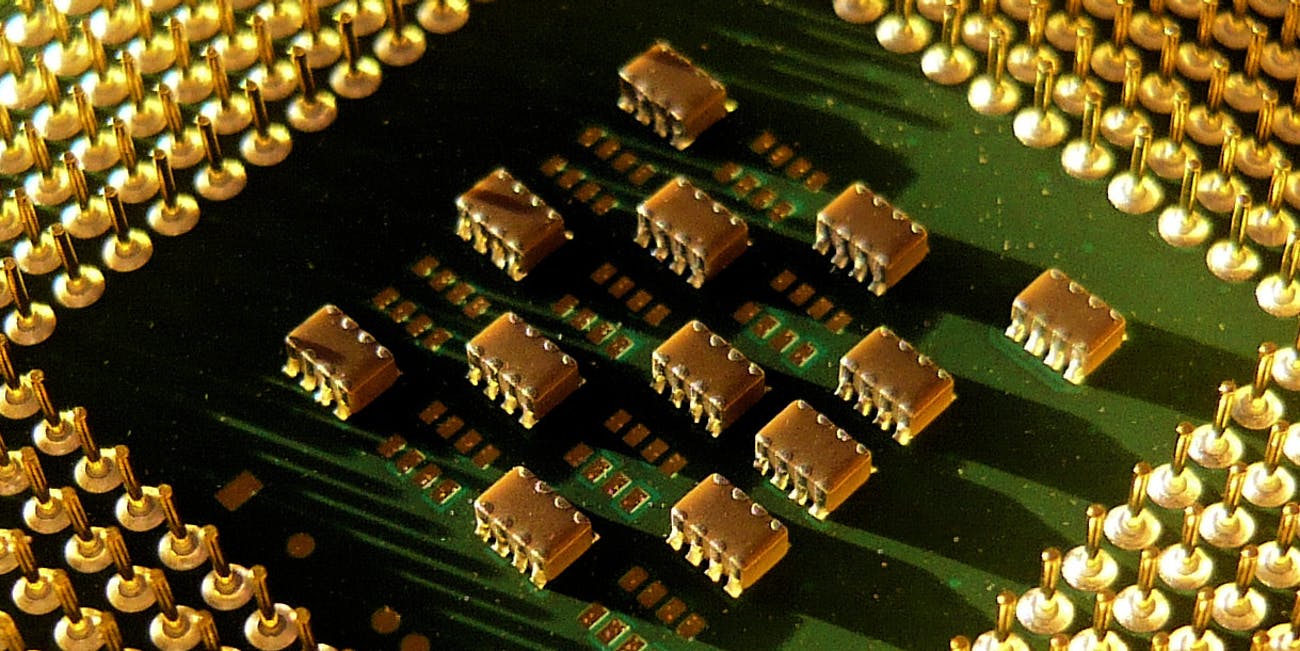

Współczesne procesory składają się z miliardów tranzystorów wielkości kilku nanometrów zgrupowanych na bardzo małej powierzchni. Według prawa Moore’a liczba tranzystorów w mikroprocesorze podwaja się mniej więcej co dwa lata. Niestety wzrost mocy obliczeniowych w procesorach uległ ostatnio spowolnieniu.

Powoli osiągamy bowiem granice technologiczne upakowania coraz większej liczby tranzystorów na tak małych powierzchniach. Granica, której fizycznie przekroczyć się nie da, to tranzystor o rozmiarze pojedynczego atomu oraz pojedynczy elektron służący do przełączania jego stanu z 0 do 1.

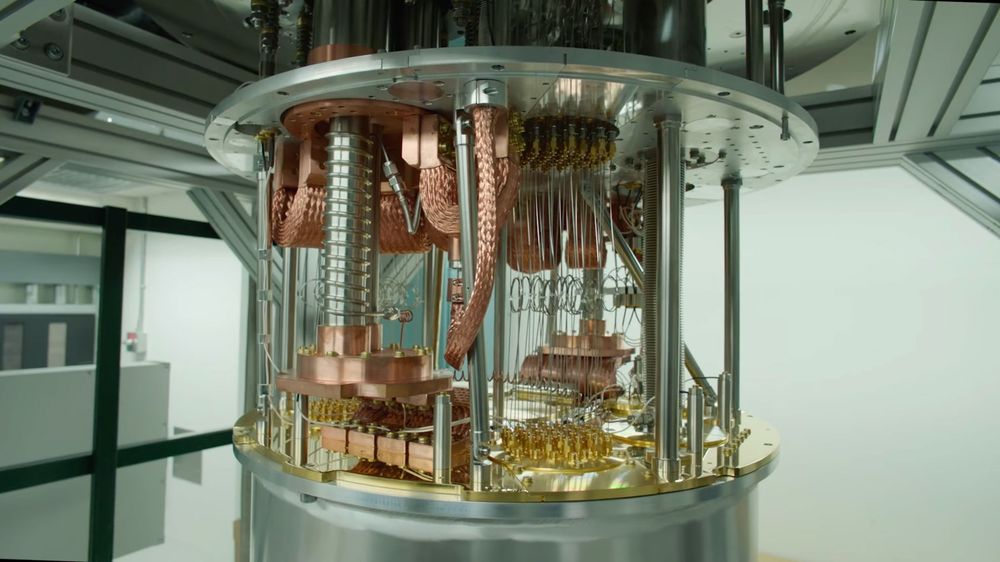

W przypadku komputera kwantowego mówimy o wykorzystaniu stanu pośredniego, czyli wyjściu poza schemat dwóch przeciwnych wartości. Kubit (od bitów kwantowych) – bo tak się nazywa jednostka urządzeń kwantowych – może przyjmować jednocześnie wartość 0 i 1, a będąc precyzyjnym – może przyjmować nieskończoną liczbę stanów między 0 a 1. Taki stan nazywa się superpozycją. Dopiero podczas sprawdzenia wartości kubita przyjmuje on jeden z dwóch stanów podstawowych – 0 lub 1.

Wydaje się, że to mała różnica, jednakże kubit znajdujący się w stanie superpozycji może podczas obliczeń wykonywać wiele poleceń jednocześnie. Pomagają nam tu podstawowe zasady fizyki kwantowej. Fizycznie kubit może być reprezentowany przez dowolny układ kwantowy o dwóch różnych stanach podstawowych: na przykład spinu elektronu lub atomu, dwóch poziomów energetycznych w atomie, czy dwóch poziomów polaryzacji fotonu – pionową i poziomą.

Ta całkowicie abstrakcyjna sytuacja nabiera realności, gdy zaczynamy mówić o użyciu komputera kwantowego. Potrafi on liczyć nawet setki tysięcy – a w założeniu miliony – razy szybciej od urządzeń zbudowanych w oparciu o zaawansowane podzespoły krzemowe!

Algorytmy probabilistyczne

Tworzenie algorytmów kwantowych jest bardzo trudne, bo muszą one być opracowywane w oparciu o zasady mechaniki kwantowej. Algorytmy wykonywane przez komputer kwantowy działają w oparciu o zasady prawdopodobieństwa (nazywamy je algorytmami probabilistycznymi). Oznacza to, że uruchamiając ten sam algorytm na komputerze kwantowym dwukrotnie, ze względu na losowość samego procesu, można otrzymać różne wyniki. Z tego wniosek, że – upraszczając – dla uzyskania wiarygodnych wyników obliczenia należy uwzględniać zasady prawdopodobieństwa.

Brzmi to jak bardzo skomplikowany proces. I niestety tak jest. Komputery kwantowe nadają się do bardzo wyspecjalizowanych, określonych obliczeń – algorytmów, które pozwolą zaprzęgnąć całą ukrytą w nich moc. Najbardziej powszechne zastosowania algorytmów probabilistycznych to test Millera-Rabina do sprawdzania, czy liczba jest pierwsza (z szerokim zastosowaniem w kryptografii) oraz Quicksort – szybki algorytm sortowania liczb. To wszystko oznacza, że komputery kwantowe nie pojawią się na każdym biurku i w każdym domu.

Jednak bez względu na to, ile czasu potrzebujemy na uzyskanie danego wyniku pracy algorytmu, możemy już dzisiaj wyobrazić sobie sytuację, w której do rozwiązania konkretnego problemu angażujemy maszynę kwantową.

Matematyka, fizyka, astronomia… i łamanie szyfrów

Technologie kwantowe mogą znacząco wpłynąć na takie dziedziny nauki jak astronomia, matematyka czy fizyka. Komputery kwantowe mogą błyskawicznie przeszukiwać olbrzymie ilości danych – być może to jest główny powód, dlaczego służby specjalne i koncerny technologiczne wiele inwestują w tę technologię. Komputery kwantowe mogą być idealnymi narzędziami do łamania szyfrów. Algorytmy kryptografii asymetrycznej, wykorzystywane jako jeden z elementów ochrony połączeń przeglądarek internetowych i połączeń w aplikacjach bankowości mobilnej i internetowej, można by za ich pomocą błyskawicznie złamać. Jest to też potencjalnie pierwsza technologia, która zagrozi algorytmom kryptograficznym sieci blockchain, a dokładnie metodom kryptograficznym opartym na parze kluczy: publicznym i prywatnym.

Chociaż moc komputerów kwantowych jest imponująca, nie oznacza to, że istniejące oprogramowanie działa po prostu miliard razy szybciej. Raczej komputery kwantowe są przeznaczone do rozwiązywania określonych typów problemów.

Mądrzejsza sztuczna inteligencja

Podstawowym zastosowaniem komputerów kwantowych może być sztuczna inteligencja, a dokładniej uczenie maszynowe (machine learning). Sieci neuronowe będące fundamentem AI muszą być trenowane, nauczone określonych zachowań w oparciu o algorytmy i ogromne ilości danych. Oznacza to, w bardzo dużym uproszczeniu, że sieci neuronowe, mając do wyboru określone działanie jako wynik obliczeń algorytmu, kierują się również prawdopodobieństwem wystąpienia określonego pożądanego wyniku działania. Dostając informacje zwrotną o tym, czy wynik działania jest pożądany lub poprawny, automatycznie korygują swoje algorytmy tak, aby zwiększyć szansę wystąpienie działania pożądanego, poprawnego.

Jest to przykład uczenia maszynowego w oparciu o informację zwrotną. Ten model działania opiera się w wielkim skrócie na obliczeniu prawdopodobieństwa wielu możliwych wyborów. Sztuczna inteligencja jest idealnym kandydatem do obliczeń kwantowych, gdzie elementy probabilistyczne są podstawą działania algorytmów komputerów kwantowych.

Komputery kwantowe i sztuczna inteligencja mają również inną wspólną cechę: ogromną, wykładniczą skalowalność. Moc komputerów kwantowych jest mierzona w kubitach, przy czym najbardziej zaawansowane komputery kwantowe mają moc około 50 kubitów. Przy takiej mocy są one odpowiednikiem jednego superkomputera. Zwiększenie tej mocy do zaledwie 60 kubitów oznaczałoby przekroczenie mocy obliczeniowej wszystkich superkomputerów na świecie.

Quantum machine learning to najnowsza sfera badań naukowych i powstająca technologia, która próbuje wykorzystać moc komputera kwantowego, aby zwiększyć szybkość klasycznych algorytmów uczenia maszynowego. Dzisiejsze systemy sztucznych inteligencji i ich algorytmy uczenia maszynowego są już zdolne do przetwarzania gigantycznych ilości informacji. Proces, w którym te algorytmy przeszukują bazy danych zyskałby na mocy obliczeń kwantowych. Szacuje się, że za kilka lat takie algorytmy i moce komputerów kwantowych będą dostępne. Ale wtedy czeka nas nie tylko skokowy wzrost szybkości sieci neuronowych. Mówimy o wzrostach rzędu milionów razy.

Samoreplikująca się sztuczna inteligencja, mogłaby skalować się wraz z rozbudową sprzętu czy sieci obliczeniowej w chmurze. Pozwalało by to sztucznej inteligencji tworzyć samodzielnie algorytmy o wiele bardziej złożone niż algorytmy które mógłby stworzyć człowiek. A wszystko to po to, by wykorzystać w pełni moc obliczeń kwantowych.

Na przykład, jeden z koncernów lotniczych planuje wykorzystać komputer kwantowy w celu testowania oprogramowania autopilota samolotu. Najnowsze modele zachowań sieci neuronowych i algorytmów, według których ten autopilot działa, są zbyt skomplikowane dla klasycznych komputerów. Komputery kwantowe są też wykorzystywane do projektowania oprogramowania, które może odnaleźć i oznaczyć pojazdy autonomiczne.

Osiągnęliśmy już punkt, w którym sztuczne inteligencje tworzą nowe sztuczne inteligencje bez udziału człowieka. A wszystko to dzięki komputerom kwantowym i zasadom fizyki kwantowej, która jest fundamentem działania tych maszyn.

Kwantowe finanse

Nowoczesne rynki finansowe tworzą jedne z najbardziej skomplikowanych ekosystemów na świecie. Choć powstało wiele skomplikowanych narzędzi matematycznych, które miały zarządzać tymi rynkami, ciągle są one nieefektywne.

Dla każdego asset managera zarządzającego funduszem inwestycyjnym zaprojektowanie idealnie zoptymalizowanego portfela jest niespełnionym marzeniem. Za każdym razem, gdy dopasowuje on swój portfel inwestycyjny (rebalancing), zmieniając wagi składników portfela, kupuje lub sprzedaje aktywa w portfelu w celu utrzymania pierwotnego pożądanego poziomu alokacji aktywów. Przykładowo pierwotna docelowa alokacja aktywów w portfelu miała wynosić 50% akcji i 50% obligacji. Gdyby akcje w portfelu osiągnęły dobre wyniki w danym okresie czasu, mogłoby to zwiększyć wagę akcji portfela do 70 proc. Asset manager, żeby powrócić do zakładanych 50/50, powinien podjąć decyzję o sprzedaży części akcji i zakupie obligacji. Oznacza to straty wynikające z kosztów transakcyjnych, a na rynku, gdzie większość funduszy osiąga krótkoterminowo zyski jednocyfrowe, strata kilku procent kosztów transakcji w wyniku dopasowania portfela inwestycyjnego może oznaczać ogromne koszty. A taki proces dopasowania portfela może być wykonywany kilkakrotnie w okresie sprawozdawczym na takim portfelu.

Komputery kwantowe mogą optymalizować portfolio inwestycji znacznie szybciej niż algorytmy wykorzystywane w tradycyjnych komputerach, nie wspominając o człowieku.

To tylko jeden z przykładów na to, jak komputery kwantowe mogą poradzić sobie z poważnymi wyzwaniami, przed jakimi stoją zarządzający funduszami. Za kilka lat algorytmy kwantowe powinny być na tyle stabilne, by zastępować ludzi w projektowaniu i zarządzaniu portfelem inwestycyjnym.

Chociaż fizyka kwantowa pod postacią komputerów kwantowych ma już teraz ogromny wpływ na obszary, które wymieniłem powyżej, z pewnością można sobie wyobrazić wiele innych jej zastosowań Technologia kwantowa i algorytmy kwantowe ewoluują. Co przyniosą? Mam nadzieję, że dużo dobrego.

Powiązane artykuły

– Kiedy przestaniemy być biologicznymi ludźmi?

– Sztuczna inteligencja to nowa elektryczność

– Tylko Bóg potrafi policzyć równie szybko, czyli świat komputerów kwantowych

NorTom2

Nawet jeśli obliczenia kwantowe dojdą do punktu, w którym podpisy cyfrowe mogą zostać naruszone, teraz oznacza to, że ktoś musiałby być w stanie skompromitować podpis cyfrowy w czasie między przesłaniem go do sieci a potwierdzeniem wydania środków, a następnie podpisać inną transakcję i dokonać podwójnego wydatkowania w czasie krótszym, niż 10 minut.

AKieszko

Dobrze, że coś ruszyło. Miejmy tylko nadzieje, że moc obliczeniowa komputerów kwantowych będzie wykorzystywana do rozwoju nauki i technologii, a nie do jeszcze lepszego analizowania zainteresowań klientów i trafniejszego dopasowywania reklam.

CabbH

Nie ma odpowiedzi bo to są pytania esencjalne i jako takie nie są częścią nauk ścisłych. Nauki ścisłe odpowiadają jedynie na pytania ilościowe. Istota danej rzeczy to pole spekulacji dla filozofii, pomiary i badanie relacji i zmian w czasie – nauki takiej jak fizyka. Żeby robić pomiary i używać wyników tychże pomiarów nie trzeba w ogóle rozumieć istoty danego zjawiska.

CabbH

Komputer kwantowy to ślepy zaułek. Przecież ludzkość nie zrozumiała jeszcze genezy elektronu. Zapytajcie dowolnego naukowca kwantowego jak wyznacza się masę dla kwarków, a usłyszycie bełkot. Zapytajcie dlaczego elektron ma spin i skąd się bierze i co drugi rozpłacze się z frustracji pitoląc o obserwacjach i doświadczeniach wskazując jakieś poprawne modele matematyczne, które są nie rzeczywiste. Zapytajcie dlaczego próżnia ma nie zerową energię i dostaniecie taki bełkot, że ze śmiechu padniecie.

CabbH

Feynman powiedział: ktokolwiek twierdzi że rozumie mechanikę kwantową, kłamie albo jest szalony” . A tu okazuje się że to nie przełom, to o płynne działanie android tv chodzi.

Krzysztof Bikowski

bez szans. Przełożenie algorytmu na krypto na coś takiego zajmie kolejne 2 dekady i nie jest nikomu potrzebne. Mają dużo naukowego stuffu do przeliczenia, spora część z niego pomogłaby przy np. kolonizacji Marsa. I raczej nie zobaczysz przez najbliższą dekadę kwantowego kompa do zabawy prywatnej. Amazon ma udostępnić jakieś kwantowe maszynki (5-10 kubików) pewnie na początku w okolicach 2500$/min i dla wybranych.

JacekPaczka

Kryptografia kwantowa oparta o tzw. splątanie fotonów korzysta z tego faktu, iż dołożenie kolejnego miernika do pomiaru sprawia, że pomiar na wszystkich miernikach się zmienia – dlatego pomiaru trzeba dokonać w tym samym t (zmiana propaguje z prędkością światła). Dokładając kolejny miernik wykrywamy że ktoś podsłuchuje nic więcej. Nie ma to żadnego zastosowania praktycznego. Nie można przenosić tej informacji na dowolną odległość bo wystarczy zabrać/przesłonić źródło oscylacji (elektron) i wszystkie tzw. fotony znikną lub nabierają innych właściwości – drgający elektron jest źródłem informacji a nie sama fala (tzw. fotony) generowana przez drgający elektron. Sama fala (tzw. foton) zmienia swoje właściwości (spin) na całym okręgu bo weszła w interakcję z miernikami. Badając tzw. foton badamy elektron jednak robiąc to zmieniamy informację na całym 'okręgu’ – fali kołowej na tafli jeziora pochodzącej z oscylacji. Fala jest właściwością oscylatora i otoczenia z którym wchodzi w interakcje.

Piotr Kieczuch

Splątanie kwantowe nie tworzy kopii, bo z twierdzenia o nieklonowaniu tworzenie kopii stanu nie jest możliwe. Splątanie kwantowe łączy stany i powoduje że nie jest to już superpozycja zera i jedynki, tylko dwóch zer, dwóch jedynek, zera z jedynką i jedynki z zerem. Jest to po prostu trick, który jest częścią algorytmów, ani ich nie przyspiesza ani nie zwiększa dokładności, po prostu czyni je możliwymi. I jest prosty, bramka H i CNOT.

Jacek Czyz

Na grubo, ale fajnie

Oskar 111

Jak na razie top nie ma jeszcze komercyjnie działającego komputera kwantowego

PiotrDomski

Może tak, może nie – kto wie?

NorTom2

Bardzo dobry wpis

MJarosz99

Patentowac to sobie moga. Po pierwsze wiekszosc cywilizowanego swiata nie uznaje patentowania algorytmow a po drugie nauka z Chin jest tak kiepskiej jakosci, ze juz wiekszosc duzych wydawnictw ma powolane specjalne dzialy do dilowania z Chinczykami by odsiewac plagiaty, publikacje z bledami metodologicznymi, z naciaganymi danymi czy tez zwykle w swiecie circlejerki gdzie grupy kolesi wzajemnie sie cytuja i wzajemnie recenzuja.

No i nie zapominajmy o najwazniejszym. Jak na razie to ledwie jestesmy w stanie zapobiegac samoistnej dekoherencji systemow kwantowych i zupelnie nie wiemy jak radzic sobie z tym, ze uklad kwantowy ulega dekoherencji w chwili odczytania jego stanu (cos na zasadzie autozniszcenia tranzystorow w CPU po wykonaniu jednej operacji i podaniu wyniku).

MJarosz99

Niby kwantowe, to znaczy klasyczne bramki symulujące stan super pozycji. Tak od zawsze się dzieje, że najpierw jest coś symulowane by sprawdzić możliwości. Oraz założenia, spodziewany efekt. To jednak bardziej komplikuje konstrukcję. Czyli mniej jest efektywnego zastosowania takiej elektroniki. Rośnie jej złożoność, a maleje przepustowość. Czy zatem gra warta świeczki? Według prognoz, to sam efekt kwantowy ma lawinowo zwiększyć wydajność obliczeń. Czyli zniwelować straty mocy obliczeniowej, powstałe wskutek bardziej złożonych systemów konstrukcyjnych. W stosunku do mocy obliczeniowej tradycyjnie złożonych konstrukcyjnie układów. Czyli moc obliczeniowa powinna wzrosnąć już po zastosowaniu bramek typu super pozycji. Tak że klasyczny układ, o podobnej złożoności technicznej, miałby jednak mniejsza moc obliczeniową. To założenia, czy są potwierdzone? Wypadało by o tym napisać. To do autora tematu. Bo że technika typowo w kwantowym wydaniu, była by wielkim postępem to nie ulega wątpliwości. Sprawa tylko, a raczej aż opracowań konstrukcyjnych takich systemów. Jak dotąd to zasady pracy w bardzo niskich i super stabilnych temperaturach, ograniczają takie systemy do stosunkowo jeszcze małej wydajności. Tu może z pomocą by przyszła przestrzeń kosmiczna. Gdzie jest już z zasady bardzo niska temperatura. Więc komputery kwantowe w przestrzeni kosmicznej, bardziej by miały sens swego istnienia. A my spijalibyśmy tylko owoce ich pracy, łącząc się z komputerami satelitarnymi. Bo tak należało by je nazwać. No trochę pofantazjowałem, bo sam nie buduję przynajmniej jeszcze komputera kwantowego.

DCzaj

W tym roku był zaprezentowany w USA komputer kwantowy o 500 kubitach! IBM pokazał zminiaturyzowany komputer kwantowy, który będzie sprzedawany masowo (komercyjny). Odkryto technologię budowy tranzystorów kubitowych (kwantowych) bez chłodzenia. Włosi ostatnio pokazali kwantowe sieci neuronowe, miljardy razy szybsze od konwencjonalnych. Demon sztucznej inteligencji powoli schodzi na Ziemię.

AndrzejP34

Gdzie niby ten ogromny wpływ komputerów kwantowych na opisane obszary, skoro te maszyny jeszcze nie wyszły na dobre z fazy testów?

AKieszko

Super wpis