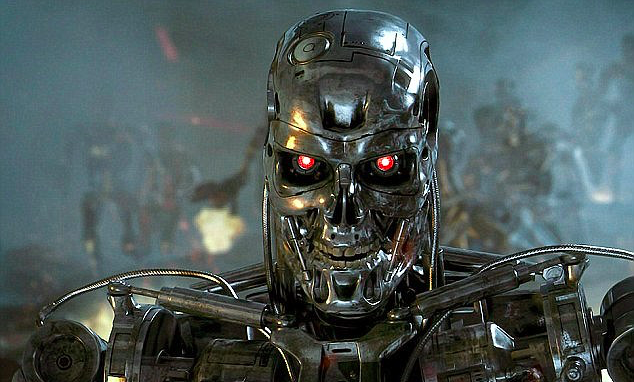

Współczesne algorytmy mogą przybierać urokliwe formy – na przykład robot Sophia zachwyca swoją filozoficzną postawą.Niektóre jednak przypominają brutalnego robocopa, który umie biegać, pokonywać trudne przeszkody i strzelać, budząc przy tym niepewność i grozę.

Czy tego – jako cywile – chcemy, czy nie, sztuczna inteligencja w przemyśle wojskowym to już fakt. Świat nieustannie testuje elektroniczne systemy dowodzenia i szkoleń, techniki rozpoznawania obiektów i algorytmy zarządzające bezzałogowymi dronami, które dostarczają wojskowym miliony fotografii i innych cennych danych. Co więcej często decyzje o uruchomieniu broni ofensywnej wypracowywane są przez maszyny, które pozostawiają człowiekowi jedynie rozstrzygnięcie, czy naciśnięć spust, czy nie. W przypadku broni defensywnych bardzo często decyzje podejmowane są przez maszyny już w pełni autonomiczne, bez udziału człowieka (np. systemy obronne czołgu czy helikoptera bojowego).

Co jest bronią autonomiczną?

Dzisiaj oczywisty jest fakt, że wojsko wykorzystuje inteligentną technologię. Zresztą wiele innowacji, które znamy z życia w cywilu, zawdzięczamy inwencji wojskowych (prekursor internetu Arphanet, czy pojazdy autonomiczne opracowywane przez DARPA). Istotne jest jednak to, na ile nowoczesna broń wykorzystująca techniki machine i deep learning, może faktycznie stawać się organizmem autonomicznym. Takim, który po analizie danych elektronicznych (temperatura, dźwięk, fotografie obiektów, geolokalizacja) potrafi podjąć samodzielną decyzję o ataku i następnie przeprowadzić go bez osoby nadzorującej. Śmiercionośna broń autonomiczna (LAW) jest więc rodzajem autonomicznego wojskowego robota, który może samodzielnie wyznaczać cele. Oficjalnie, przedstawiciele wojska twierdzą, że żaden z współczesnych systemów uzbrojenia nie jest w pełni autonomiczny. Przyznają jednak, że coraz większa część arsenału spełnia technologiczne warunki ku temu, by działać niezależnie.

Warto też zwrócić uwagę na inny aspekt. Chociaż systemy zakładają, że kluczowe decyzje podejmuje człowiek, to często wymagany czas ludzkiej reakcji jest tak krótki, że wyklucza jakichkolwiek rozważania. Gdy ktoś ma pół sekundy na decyzję o naciśnięciu spustu, trudno mówić o pełnej autonomii… jednostki ludzkiej.

Myślące drony, statki i samoloty

Raporty Human Rights Watch, organizacji monitorującej m.in. inicjatywy wojskowe, wymieniają szereg systemów częściowo autonomicznej broni rozmieszczonych na świecie. Co najmniej 380 urządzeń militarnych wykorzystujących wyrafinowaną, inteligentną technologię działa w Chinach, Rosji, Francji, Izraelu, Wielkiej Brytanii i Stanach Zjednoczonych. Ostatnio głośno zrobiło się o firmie Hanwha, która należy do grupy największych producentów broni w Korei Południowej.

Gazeta „The Korea Times” poinformowała, że firma we współpracy z Koreańskim Instytutem Zaawansowanej Nauki i Technologii (KAIST) pracuje nad pociskami, które mogą kontrolować prędkość i wysokość, a także zmienić kurs, bez bezpośredniej interwencji człowieka. Do samodzielnego działania jest już rzekomo zdolne (programiści jednak twierdzą, że jego użycie ciągle wymaga ludzkiej autoryzacji) działko strażnicze SGR-A1 umieszczone wzdłuż strefy zdemilitaryzowanej, między Koreą Południową a Koreą Północną.

Koreańska firma Dodaam Systems wytwarza autonomiczne roboty, oparte o skomplikowane algorytmy i sieci neuronowe, zdolne do wykrywania celów oddalonych o wiele kilometrów. W Wielkiej Brytanii od ponad czterech lat intensywnie testuje się bezzałogowy dron Taranis, który pełnie możliwości ma osiągnąć w 2030 roku, zastępując samoloty pilotowane przez człowieka. W zeszłym roku agencja Tass poinformowała, że rosyjskie samoloty bojowe zostaną wkrótce wyposażone w pociski samosterujące, zdolne do analizy sytuacji i samodzielnych decyzji dotyczących wysokości, prędkości i kierunku lotu. Wiadomo też powszechnie, że Chiny, które chcą być liderem, jeśli chodzi o technologie sztucznej inteligencji, intensywnie pracują nad dronami (ze szczególnym uwzględnieniem dronów, które operowałyby grupowo, w tzw. „rojach”) zdolnymi do przenoszenia pocisków samosterujących i samodzielnie wyszukujących cele.

Amerykańskie marzenia

Od 2016 r. w ramach amerykańskiego Departamentu Obrony powstaje centrum rozwoju sztucznej inteligencji. Według twórców programu, postępy w tej dziedzinie zmienią naturę działań wojennych, a wojsko ma być poważnym beneficjentem technologicznego rozwoju. Chociaż były amerykański wiceminister obrony Robert O. Work stwierdził, że wojsko nie przekaże władzy maszynom, to może kiedyś być zmuszone do poważnej refleksji nad tym, czy tego nie zrobić (ze względu na postawę reżimów autorytarnych). Póki co można być pewnym, że agencja od dwóch lat realizuje już szeroki, wielomiliardowy program sztucznej inteligencji i ma on kluczowe znaczenie dla strategii Stanów Zjednoczonych. Amerykańska armia testuje nowoczesne, zdalnie sterowane urządzenia, takie jak Extreme Accuracy Tasked Ordnance – „inteligentną” amunicję strzelecką, która potrafi samodzielnie określać cele i zmieniać kurs lotu, uwzględniając prędkość wiatru. Wszytko to w oparciu o wstępnie przygotowane algorytmy. Na militarnej scenie coraz lepiej czują się bezzałogowe drony latające, które – według ekspertów – w ciągu najbliższych lat całkowicie zastąpią samoloty sterowane przez pilotów. Te maszyny to często bezzałogowe aparaty latające zdolne do tankowania w powietrzu, wykonywania misji zwalczania obrony przeciwlotniczej, realizowania misji zwiadowczo-rozpoznawczych, atakowania celów naziemnych. Okazuje się, że rezygnacja z pilota przynosi wymierne korzyści ekonomicznym. Systemy podtrzymywania i ochrony życia pilota w nowoczesnym myśliwcu mogą stanowić do 25% kosztów całej platformy bojowej.

Nanoboty też walczą

Trwają prace nad wykorzystaniem potencjału tzw. owadzich robotów – specyficznej formy nanobotów, które w opinii amerykańskiego fizyka Louisa Del Monte, autora książki „Nanoweapons: A Growing Threat To Humanity”, mogą stać się bronią masowego rażenia. Według autora, nanoboty przypominające owady, można już programować do wstrzykiwania ludziom toksyn i zanieczyszczania wody w sieciach wodociągowych. Na tego typu prace wskazuje również stacja CNBC, która opisała realizację programu „Szybka lekka autonomia” wdrażanego przez DARPA. W jego ramach toczą się prace nad dronami wielkości muchy, które będą dostawać się do dowolnego urządzenia, by je następnie inwigilować. Izrael także przyznał, że prowadzi zawansowane prace nad tego typu owadzimi dronami. Mają być gotowe do użycia w ciągu najbliższych trzech lat.

Organizacje pozarządowe monitorują

Politycy, eksperci, przedstawiciele biznesu informatycznego coraz bardziej sobie uświadamiają, że problem związany z istnieniem broni autonomicznej nie jest abstrakcją. Od kilku lat powstają coraz szersze i mocniejsze inicjatywy nagłaśniające te kwestie. Stany Zjednoczone powinny „zobowiązać się do wynegocjowania wiążącego traktatu i wytyczenia granic autonomii systemów uzbrojenia. Powinien on uniemożliwić rozwój, produkcję i wykorzystanie w pełni autonomicznej broni” – twierdzi Mary Wareham przedstawicielka Human Rights Watch. Aktywistka i reżyserka prowadzi regularne działania monitorujące w ramach międzynarodowej koalicji – projektu „Campaign to stop killer robots”.

Z kolei brytyjska organizacja pozarządowa „Article 36”, która poświęca wiele uwagi broni autonomicznej twierdzi, że polityczne kontrole uzbrojenia powinny być regularne i oparte na publicznie dostępnych, przejrzystych analizach. Obie organizacje wkładają mnóstwo energii w to, by doprowadzić do wypracowania jasnych definicji dotyczących broni autonomicznej. Sygnatariusze międzynarodowych petycji próbują docierać do polityków i przedstawiają swój punkt widzenia na międzynarodowych konferencjach. Jedną z ostatnich inicjatyw międzynarodowych jest tegoroczny list sygnowany przez bostońską organizację Future of Life Institute. 160 firm związanych z technologiami sztucznej inteligencji w 36 krajach i 2400 osób, podpisało deklarację stwierdzającą, że „autonomiczna broń stanowi wyraźne zagrożenie dla obywateli każdego kraju na świecie i dlatego nie będą oni uczestniczyć w jej rozwijaniu”. Dokument podpisali m.in.: Demis Hassabis, Stuart Russell, Yoshua Bengio, Anca Dragan, Toby Walsh oraz założyciel Tesli i SpaceX Elon Musk.

Regulacje są potrzebne, ale utopijne

Sprawa z tego typu inicjatywami jest trudna. Po pierwsze obserwacja wojskowych przedsięwzięć jest z natury skomplikowana. Dopóki nie dochodzi do otwartego, międzynarodowego konfliktu, który ujawnia, jakie technologie są faktycznie w użyciu, śledzenie tego, jaką broń się rozwija i bada, instaluje jest niemal niewykonalne.

Kolejną przeszkodą na drodze do wypracowania jasnych, obowiązujących norm i ustaleń jest natura algorytmów. Okazuje się, że jesteśmy mocno przyzwyczajeni do postrzegania broni, jako materialnego przedmiotu (którego użycie może być zakazane lub nie). W przypadku, gdy mówimy o oprogramowaniu, software, algorytmach, sieciach neuronowych, a tym bardziej sztucznej inteligencji, regulacje prawne z trudem radzą sobie z niematerialnym charakterem tych narzędzi. Bardzo często zaprojektowane algorytmy rozrosły się do takich rozmiarów że przestają być kontrolowalne.

Pojawia się też problem rozmytej odpowiedzialności, o którym pisałem w tekstach o samochodach autonomicznych. Jeśli dochodzi do tragedii, to kto za nią ponosi odpowiedzialność? Informatyk programujący algorytmy tak, by mogły dokonywać samodzielnych wyborów? Czy może trener sieci neuronowych?

Wojskowi twierdzą, że chodzi o rozpoznanie

Wojskowi jednak odpowiadają, że zamiast zakazywać, należy raczej zachęcać do innowacji, które pozwolą zmniejszyć liczbę ofiar cywilnych. – twierdzą wojskowi lobbujący za najbardziej zaawansowanymi projektami. Nie chodzi tu o to, że algorytmy mają niszczyć wroga i ludność cywilną. Mają przede wszystkim pomagać w ocenie sytuacji na polu walki, analizując ją pod kątem możliwości zyskania taktycznej przewagi. W takim ujęciu inteligentne technologie prowadzą przede wszystkim do sprawniejszego przetwarzania danych. Ułatwia to następnie identyfikację obiektów i zmniejsza liczbę przypadkowych ofiar wśród ludności cywilnej.

Nie liczmy na prawa człowieka

Algorytmy uwolnione na polu walki mogą prowadzić do tragedii niebywałych rozmiarów. Toby Walsh, profesor zajmujący się problematyką sztucznej inteligencji na Uniwersytecie Nowej Południowej Walii w Australii stwierdził: „Autonomiczna broń nie będzie przestrzegać praw człowieka. Maszyny mogą wędrować po polu bitwy, na ziemi lub w powietrzu, wybierając własne cele, a następnie niszcząc je ogniem lub pociskami, i to bez ludzkiego udziału”.

Sztuczna inteligencja ma olbrzymie możliwości, by pomagać ludzkości. Niestety ma też swoją ciemną stronę. Wypada więc mieć nadzieję, że politycy i wojskowi mają na tyle dużo wyobraźni, by na czas dostrzec wszystkie konsekwencje, wynikające z upowszechnienia autonomicznego uzbrojenia.

. . .

Cytowane prace

YouTube, BrainBar, My Greatest Weakness is Curiosity: Sophia the Robot at Brain Bar, link, 2018.

YouTube, Boston Dynamics, Getting some air, Atlas?, link, 2018.

The Guardian, Ben Tarnoff, Weaponised AI is coming. Are algorithmic forever wars our future?, link, 2018.

Brookings, Michael E. O’Hanlon, Forecasting change in military technology, 2020-2040, link, 2018.

Russell Christian/Human Rights Watch, Heed the Call: A Moral and Legal Imperative to Ban Killer Robots, link, 2018.

The Korea Times, Jun Ji-hye,Hanwha, KAIST to develop AI weapons, link, 2018.

Bae Systems, Taranis, link, 2018.

DARPA, Faster, Lighter, Smarter: DARPA Gives Small Autonomous Systems a Tech Boost, Researchers demo latest quadcopter software to navigate simulated urban environments, performing real-world tasks without human assistance, link, 2018.

The Verge, Matt Stroud, The Pentagon is getting serious about AI weapons, link, 2018.

The Guardian, Mattha Busby, Killer robots: pressure builds for ban as governments meet, link, 2018.

. . .

Powiązane artykuły

– Kto zyska a kto straci na rewolucji cyfrowej?

– Kiedy przestaniemy być biologicznymi ludźmi?

– Sztuczna inteligencja to nowa elektryczność

– Tylko Bóg potrafi policzyć równie szybko, czyli świat komputerów kwantowych

Tom Aray

Ten argument jest spoko do momentu do którego zostają jeszcze JAKIEKOLWIEK prace jakie możesz wykonywać.

Gorzej, że dojdziemy do momentu w którym nie będzie żadnych prac dla ludzi. Sztuka – AI sobie poradzi równie dobrze. Entertainment? Nie każdy może w nim pracować.

Docelowo świat musi przejść taką transformację. Cała praca wykonywana przez maszyny, każdy dostaje przydział – taki sam i równy – z ich pracy i tyle. Taki system trochę działa już na stacjach kosmicznych czy może na Marsie wkrótce. Równy przydział.

Andrzej Maczalski

Czyli co, mamy sztucznie hamować rozwój bo ktoś się nie umie przekwalifikować? Teraz już w momencie zatrudnienia powinniśmy trzymać rękę na pulsie w zakresie szukania nowej pracy, bo rynek jest dynamiczny, a przez to niestabilny. Odnajdą się ludzie sprytni, mądrzy i inteligentni. Zawsze, w każdych warunkach, bo będą bazować na głupocie pozostałych. Bardziej niż w sztuce, którą da się wytworzyć z użyciem AI, upatrywałabym szansę na zwiększenie zatrudnienia w branży edukacji i szkoleń. Wszak trzeba będzie wszystkich w pewnym momencie obudzić z zimowego snu

Mac McFisher

Tak jak razem wypracowywaliśmy reguły etycznego postępowania, tak razem powinniśmy projektować algorytmy. Zespoły nad nimi pracujące powinny być zróżnicowane środowiskowo, kulturowo i geograficznie. W ten sposób zminimalizujemy ryzyko wadliwych algorytmów, wypaczonych danych, a przed wszystkim ich wykorzystanie przez szalone jednostki.

KrzysiekC

Już nas zabijają: drony wojskowe

Dzikus99

Mam nadzieje ze nie, bo to kiepska perspektywa

TomaszKik

ale wpis zacny

TomaszKik

Nie podoba mie sie taka przyszłość

Robert Kaczkowski

Mam nadzieje że tego nie dożyje

Jacek B2

Przeciez juz nas zabijają. Nie jest to nowość

TomaszK1

Bardzo dobry, chociaż troche przerażający wpis

Norbert Biedrzycki

Wodze fantacji 🙂

Grzegorz Wiatr

Dobre. A to nie było już poprzednio opublikowane? Gdzieś już czytałem ten Pana artykuł

Norbert Biedrzycki

Tak, na kanałach social media 🙂

Andrzej44

Bardzo dobry temat. Do rozwinięcia dalej. Poprosze

Norbert Biedrzycki

Top 8 Ethical Concerns for AI