Każdy z nas podejmuje codziennie szereg decyzji, w których istotne są kwestie etyczne. W dużej części nasze codzienne wybory między dobrem a złem są automatyczne, często przez nas niezauważalne. W świecie Sztucznej Inteligencji kwestia moralności staje się zaś coraz bardziej problematyczna. Czy roboty zaczną grzeszyć?

Technologie oparte na algorytmach, uczeniu maszynowym i automatyzacji procesów znajdują się na takim etapie rozwoju, że pytania i odpowiedzi dotyczące moralności, mogą poważnie wpłynąć na rozwój całej nowoczesnej technologii, a nawet naszej cywilizacji.

U podstaw rozwoju Sztucznej Inteligencji leży wiara w to, że świat może być lepszy. Ludzie mogą być zdrowsi i żyć coraz dłużej, zadowolenie klienta z oferowanych mu usług i dostarczanych produktów stanie się coraz większe, prowadzenie samochodu będzie wygodniejsze i coraz bardziej bezpieczne, a technologia w naszych inteligentnych domach nauczy się rozumieć nasze intencje i potrzeby. Taka właśnie, może nieco utopijna, wizja musiała pojawić się w wyobraźni twórców systemów informatycznych, by mógł dokonać się wielki postęp technologiczny, który nadal trwa. Kiedy wreszcie przekonaliśmy się, że nowatorskie produkty i usługi (komputery rozumiejące język naturalny, systemy rozpoznawania ludzkiej twarzy, pojazdy autonomiczne, inteligentne domy, roboty) rzeczywiście da się stworzyć, to doszliśmy do etapu przeżywania wątpliwości, rozterek i zadawania pytań. Koncerny technologiczne mają świadomość tego, że za ich abstrakcyjnymi, niematerialnymi wytworami (oprogramowanie, algorytmy) ukryte jest podstawowe, klasyczne i poważne pytanie o dobro i zło. Poniżej wskażę na kilka podstawowych wyzwań o charakterze etycznym, które prędzej czy później będą wymagały od nas podjęcia jednoznacznych decyzji.

Rewolucja w prawie.

Duże kancelarie prawne w Stanach Zjednoczonych podejmują w ostatnich latach intensywną współpracę zarówno z etykami jak i programistami, dla których praca nad nowymi algorytmami to chleb powszedni. Te aktywności w przeważającej części wynikają z postawy polityków amerykańskich, którzy mają pogłębiającą się świadomość tego, że systemy prawne nie nadążają za zmianami, które niesie za sobą technologia. Uważam, że jednym z największych wyzwań dla dużych społeczności, państw i narodów jest konieczność podjęcia systemowych działań legislacyjnych zmierzających do uregulowania kwestii prawnych dotyczących Sztucznej Inteligencji. Jest to potrzebne zarówno ze względu na poczucie naszego bezpieczeństwa, jak i po to, by całe dziedziny związane z technologiami informatycznymi mogły się dalej rozwijać. Wdrożeniom technologicznym i implementacjom technologii w biznesie nie może towarzyszyć wyłącznie intuicja, zdrowy rozsądek czy działanie w oparciu o zasadę „co nie jest zabronione, jest dozwolone”. Przecież prędzej, czy później ofiarami braku odpowiednich regulacji mogą stać się nie tylko postronni ludzie, ale również i ci, którzy dzisiaj podejmują kluczowe decyzje.

Linia produkcyjna w fabryce Foxconn

Regulacje rynku pracy.

Robotyzacja całych dziedzin przemysłu staje się faktem. Na takich obszarach jak logistyka, BIG DATA, magazynowanie dóbr – udział robotów będzie się systematycznie zwiększał. Nie bez przyczyny jest to chyba najczęściej pojawiający się wątek w rozważaniach dotyczących Sztucznej Inteligencji. Dyskusjom tym towarzyszy często irracjonalny lęk, który może stać się narzędziem ułatwiającym doraźne korzyści wielu grupom społecznym, włącznie z kręgami politycznymi. Co zrobić, by straszenie robotami nie weszło nam w krew? Jednocześnie, jak rozwiązać takie kwestie jak utrata pracy przez człowieka i zastąpienie go maszyną? Czy rozwiązaniem mogą stać się podatki nakładane na firmy o wysokim stopniu robotyzacji? Czy pracodawcy powinni być świadomi odpowiedzialności moralnej, jaka wiąże się z faktem zatrudnienia robota, który może na pewnych obszarach kontrolować pracę człowieka? Kategorie dobra i zła są tutaj szczególnie istotne i trudno je bagatelizować. Automatyzacja i robotyzacja wielu gałęzi przemysłu niesie korzyści, ale może oznaczać też rodzenie się mechanizmów wykluczających i wpływać na pogłębianie się nierówności społecznych. To są prawdziwe wyzwania naszych czasów i nie możemy udawać, że są to kwestie abstrakcyjne.

Kontrola oprogramowania

Według futurologa Raya Kurzweila czeka nas wkrótce powstanie osobliwości, superinteligencji. Jest to ten okres w rozwoju cywilizacyjnym i technologicznym, kiedy zdolności obliczeniowe wszystkich komputerów zaczynają przewyższać umiejętności przetwarzania informacji przez ludzki mózg. Wielu antropologów kultury traktuje to, jako rodzaj doświadczenia granicznego i moment prawdziwych narodzin Sztucznej Inteligencji, a może też jej uniezależnienie się od człowieka. Czy jeśli ta hipoteza ma sens, to oznacza, że systemy Sztucznej Inteligencji potrzebują jakiegoś specjalnego nadzoru? Na czym miałby on polegać? Jak stworzyć standardy w przemyśle informatycznym, które pozwoliłyby na rozróżnienie kategorii zachowań, projektów, produkcji dozwolonych od niedozwolonych? Według Jonathana Zittraina, profesora prawa z Harvardu rosnąca złożoność systemów informatycznych, które są ze sobą coraz bardziej powiązane, powoduje, że kontrola nad nimi staje się niemożliwa. A to może oznaczać szereg niebezpieczeństw łącznie z tym, że kategorie moralne staną się trudne do obrony, czy do utrzymania.

Ray Kurzweil: Nadchodząca osobowość

Autonomiczne pojazdy dokonują wyborów

Kilka miesięcy temu pisałem o kwestiach etycznych związanych z faktem pojawienia się na naszych drogach autonomicznych pojazdów. Opisywałem, że samochody będą musiały dokonywać etycznych wyborów na drodze, co będzie też w konsekwencji oznaczać problem odpowiedzialności dla konkretnych ludzi – programistów tworzących algorytmy czy prezesów koncernów samochodowych. W sytuacji, gdy na drogę w wybiega dziecko, autonomiczny samochód musi niejako sam wybierać, co robić. A te jego wybory będą zależne od tego, jakie algorytmy zostały wykorzystane do jego funkcjonowania. Można teoretycznie wybrać trzy drogi w – nazwijmy to – etycznym programowaniu algorytmów. Pierwsza zakłada, że w sytuacji wypadku i zagrożenia życia, liczy się solidarnie dobro wszystkich uczestników wypadku (czyli kierowca, pasażerowie i dziecko na drodze). Druga wskazuje na to, że najważniejsze jest życie pieszych i uczestników ruchu. W trzecim ujęciu, priorytetem jest ochrona życia kierowcy i pasażerów. Wszystko więc zależy, jaki algorytm będzie w tym przypadku decydujący i na jaki zdecyduje się dana firma. Spośród tych wariantów zachowań producenci będą musieli wybrać najbardziej korzystny – biorąc pod uwagę korzyści biznesowe, warunki ubezpieczenia i zasady etyki. Bez względu na to, który wybiorą, będą też musieli zadbać o ochronę prawną swoich programistów piszących algorytmy.

Jak zachować prawo do prywatności?

Pojęcie prywatności to kwestia wyjątkowo drażliwa w naszych czasach. Nasze dane osobowe są przetwarzane w zasadzie nieustannie przez zautomatyzowane procesy biznesowe i marketingowe. Nasz pesel, nazwisko, historia naszego poruszania się w internecie, zakupów – stała się przedmiotem zainteresowania wszystkich korporacji świata. Żyjąc w zglobalizowanym świecie poddawani jesteśmy nieustannym naciskom – mniej lub bardziej subtelnym – by te nasze dane udostępniać na każdym kroku.

Czym jest prywatność dzisiaj, czym jest właściwie prawo do jej zachowania – to pytanie jest jednym z kluczowych i dotyczy wielu przejawów naszego funkcjonowania. W erze mediów społecznościowych, kiedy każda informacja o naszym życiu została praktycznie na zawsze „kupiona” przez największe portale, nasz prywatność została w zasadzie przedefiniowana. Wprowadzając się do inteligentnego domu nafaszerowanego elektroniką, gdzie każdy sprzęt będzie uczył się naszych potrzeb, musimy zdawać sobie sprawę z tego, że efektem tej nauki będą też konkretne dane, które będą mogły być przetwarzane i udostępniane. Pytanie o to, czy nasze prawo do zachowania przestrzeni prywatnej nie będzie z czasem jeszcze bardziej wystawione na działanie zewnętrznych sił i społecznych procesów – uważam za podstawowe.

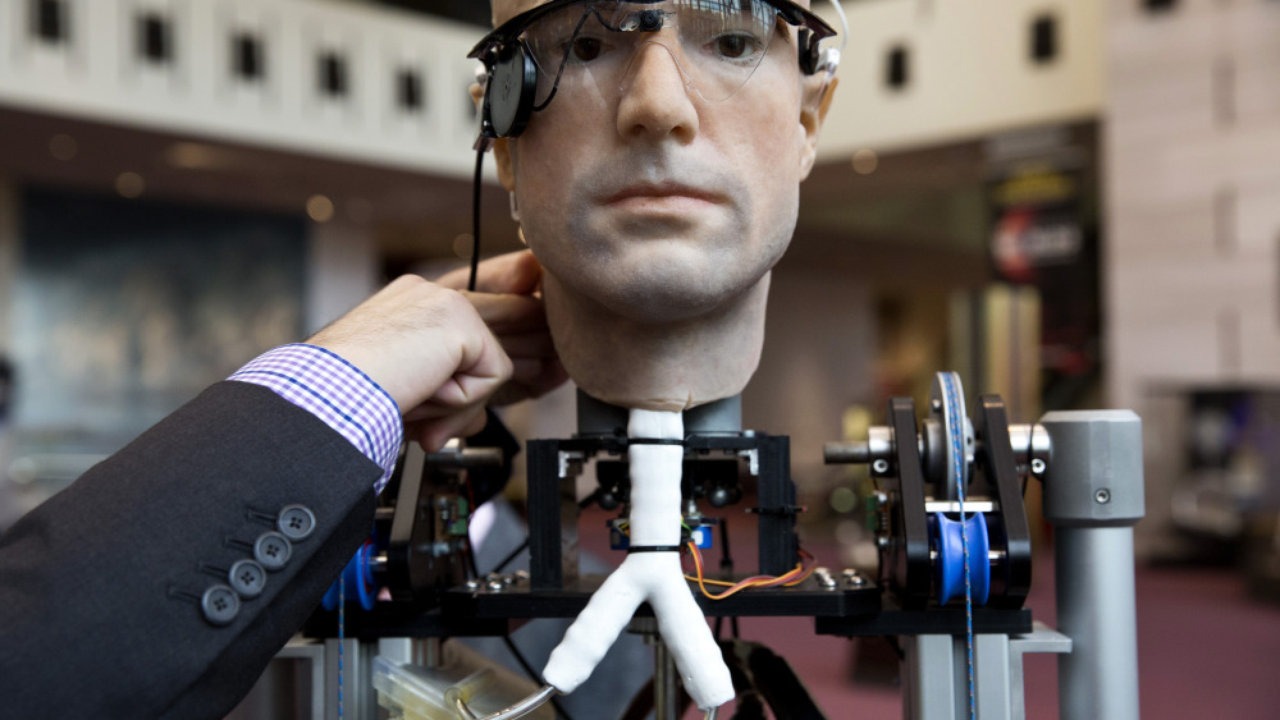

Frank – robot bioniczny zbudowany z protez i syntetycznych organów

Rządzić będą Boty

Na świecie organizowane są turnieje botów. Polegają one na tym, że ich uczestnicy poddawani są testowi Turinga, czyli klasycznej metodzie sprawdzania, czy obcujemy z komputerem, czy z człowiekiem. Nie będzie chyba dużym zaskoczeniem, że najlepsze boty osiągają wyniki ponad 50 procentowej skuteczności. Oznacza to ni mniej ni więcej, że połowa ludzi uczestniczących w eksperymencie nie jest w stanie odpowiedzieć na pytanie, czy komunikowało się z człowiekiem czy z maszyną. O ile takie laboratoryjne zawody jeszcze wyglądają jak niewinna zabawa, to wprowadzenie botów do powszechnego funkcjonowania może uruchomić szereg pytań natury etycznej. Czy mogę poczuć się przez bota okłamany lub wykorzystany? Czy może mną manipulować i wpływać na moje relacje ze współpracownikami, usługodawcami, szefem? A jeśli poczuję się oszukany, to w jakiej instancji mam szukać zadośćuczynienia? Przecież oskarżenie bota o manipulację brzmi jak bajka nie z tej planety. Maszyny zwiększają obecność w naszym życiu, zaczynają wpływać też na nasze emocje. Tutaj również pytanie o dobro i zło będzie nabierało szczególnego znaczenia.

Czy roboty odróżnią dobro od zła?

Najciekawsze pytania o charakterze etycznym dotyczą właśnie robotyzacji. I tu pojawiają się pytania analogicznie do tych, które towarzyszą obecności pojazdów autononomicznych. Dzisiejsze roboty dopiero się uczą chodzić, odpowiadać na pytania, trzymać w dłoni butelkę napoju, otwierać lodówkę, biegać. Niektóre robią to już z coraz większą naturalnością. Roboty nie tylko zastąpią nas w wielu miejscach pracy. Mogą być naprawdę pomocne w takich obszarach życia, jak chociażby opieka nad ludźmi starszymi, wymagającymi codziennej pomocy. Jeszcze minie sporo czasu, kiedy robot stanie się istotą społeczną, „osobą” chronioną specjalnymi prawami – chociaż pytania o te kwestie już są zadawane. Ale już dzisiaj producenci robotów stają przed wyzwaniami, w których nie brakuje pytań dotyczących wyborów między dobrem i złem. Jak programować robota, by podejmował on działania wyłącznie pozytywne, nie szkodzące ludziom? By nam pomagał w każdej sytuacji, a nie przeszkadzał? Jeśli mielibyśmy ufać technologii i Sztucznej Inteligencji, to musimy zadbać o to, aby maszyna działała zgodnie z planem. Ale co to oznacza w przypadku robota? Wyobraźmy sobie sytuację, że programujemy go tak, by o określonej godzinie podawał leki osobie potrzebującej. I wyobraźmy sobie, że ta osoba nagle odmawia ich przyjęcia. Co ma zrobić robot? Czy uszanować wybór pacjenta? Kto będzie odpowiadał i ponosił konsekwencje prawne dotyczące wyboru maszyny w opisanej sytuacji?

Prawa Robotyki Isaaca Asimova

Era nowej moralności?

Przedstawiłem kilka najważniejszych obszarów Sztucznej Inteligencji, w których problematyka etyczna jest lub będzie szczególnie ważna. Jednak pytań, które tu nie padły ze względu na rozmiar tekstu – jest dużo więcej. Przełom technologiczny, jaki się dokonuje na naszych czasach, niesie nie tylko jednoznaczne korzyści, czyni nasze życie wygodniejszym i lepszym. Oznacza on również wielkie wyzwanie dla naszego systemu wartości, niesie nadzieje, ale też obawy dotyczące zachwiania utrwalonych granic między dobrem a złem. Być może rewolucja jaka dokonuje się w tych dniach przyniesie globalną zmianę, która dotknie również naszego tradycyjnego pojmowania kategorii etycznych.

Powiązane artykuły:

– Maszyna cię nie przytuli, ale … wysłucha i coś doradzi

– Czy maszyny odróżniają dobro od zła?

– Machine Learning. Komputery nie są już niemowlętami

– Co pomyśli maszyna, gdy spojrzy nam głęboko w oczy?

– Upadek hierarchii, czyli kto właściwie rządzi w Twojej firmie

– Mózg, urządzenie które wypada z obiegu

– Nowoczesne technologie a stare lęki: czy roboty odbiorą nam pracę?

Andrzej Maczalski

Nie brnąc w szczegóły (i zakładając że świat jest idealny i ludzie nie są chciwi) :

Długoterminowo, automatyzacja jest cegiełką ku uniwersalnemu dochodowi

CzarekZ23

Cała ta Sztuczna Inteligencja pracuje w oparciu o przetwarzanie masy danych. Niektóre z nich należy urządzeniom po prostu dostarczyć. W przyszłości będą potrzebni pracownicy, których jedynym zadaniem będzie gromadzenie danych, po to by móc nimi „nakarmić” maszyny czy wszelkiego rodzaju urządzenia operujące w oparciu o duże zbiory rozmaitych informacji.

TomaszKik

Nie ma czegoś takiego jak sztuczna inteligencja, szczególnie w autonomicznych pojazdach. Nawet ciężko mówić obecnie o algorytmach sztucznej inteligencji bo to nazwa marketingowa i większość systemów nie spełnia i wrecz nie może spełniać technicznych kryteriów by tak je nazwać. W szczególności systemy decyzyjne w autonomicznych pojazdach w żadnej mierze nie spełniają kryteriów by stwierdzić, że zastosowano tam algorytmy sztucznej inteligencji.

Oscar2

Lubię Roy-a – jego pracę i jego publikacje, jednakże wydaje się być zbytnim optymistą w swoich prognozach…

TomekSz

Przecież w słynnym teście Turinga wcale nie chodzi o to, by chatbot był człowiekiem. On ma tylko wystarczająco przekonująco udawać człowieka. Wystarczająco, czyli tak, by jego rozmówca nie był w stanie stwierdzić, czy pogawędka, którą właśnie prowadzi toczona jest z maszyną, czy może z jakimś pomysłowym algorytmem.

Jacek Czyz

Wbrew pozorom nie jest to bardzo odległa przyszłość – robot, przekonująco odgrywający rolę partnera w łóżku pojawi się już w 2020 roku. Około 2050 roku roboty zaoferują coś więcej – umiejętność rozkochiwania w sobie ludzi.

Jacek B2

Genialna sprawa – czytając Pański artykuł, przez cały czas przez głowę przechodziła mi analogia Pani Major z Ghost In The Shell. Jeżeli połączyć tak dobrze imitująca ludzkie ciało lalkę, z kawałkiem dobrze napisanego IA, to można spodziewać się ciekawej przyszłości 😉

CabbH

Jak dotąd „świadomy” nie do końca jest zdefiniowany. Kryteria wg których należałoby oceniać taki „byt” moga być niewystarczające. Raymond Kurzweil, genialny futurysta ale też jedna z najbardziej prominentnych osób w Google LLC w 2005 pisał o możliwości stworzenia świadomego cyfrowego bytu. O ile jeszcze 10 lat temu, jego idee z ksiąski How to Create a Mind, traktowano jako czystą futurystkę, dzisiaj stają się praktycznymi pytaniami jak widać z tego artykułu.

MJarosz99

Boimy się kreatywnego myślenia i eksperymentu. W Polsce możem wdrażać nową technologię i filozofię życia, ale wymaga to zupełnie nowego podejścia i trochę fantazji i odwagi. Wydaje mi się, że umiejętności będą zupełnie inne niż kiedyś. Musimy się ich uczyć już teraz. Podstawa to chyba sama umiejętność „myślenia” i wymyślania… Czyli szeroko rozumiana kreatywność.Jak to zacząć opracowywać oddolnie, jak centralizować pewne kluczowe procesy, które wymagają większego zaangażowania kapitałowego i intelektualnego. Jeśli taki system postawiony na takim EOSie mógłby mieć wewnętrzny system kontraktów czy dystrybucji punktów do wymiany usług i wiedzy w sharing economy 🙂

Krzysztof Bikowski

Rozwój technologii przyczynia się do spadku zapotrzebowania na prace wykonywane przez ludzi. Dodatkowo część pracy przejmują sami klienci np. korzystając z usług elektronicznych lub systemów samoobsługowych. Gospodarka wymusza wzrosty efektywności poprzez automatyzację i standaryzację, co prowadzi do zastępowania ludzi automatami sterowanymi oprogramowaniem. Model ten jest z powodzeniem stosowany także w usługach (bankomaty, automatyczne systemy do tłumaczeń, analizy dokumentów itp.).

CabbH

Fajna infografika. Potwierdza to moją tezę że mnóstwo ludzi straci pracę przez rozpowszechnienie się sztucznej inteligencji, robotyzacji czy szeroko rozpowszechnionej automatyzacji. US – 46% zawodów do automatyzacji

Norbert Biedrzycki

źródło: McKinsey Global Institute. Warto czytać te raporty. Są dostępne na zewnętrznej stronie McKinsey’a. Firma chętnie dzieli się swoją wiedzą

Norbert Biedrzycki

Technical jobs automation potential by McKinsey & Company. Japan 55%, India 52%, China 51%, US 46% of all current jobs

Krzysztof Bikowski

Czyta Pan science-fiction? Skąd ten Assimov?

Norbert Biedrzycki

Cykl Fundacja. Towarzyszyła mi przez całą młodość

Andrzej44

Praktycznie niemożliwy do zatrzymania rozwój AI powoduje ze pojawiają się ważkie pytania z zakresu etyki, socjologii, jak również prawnych aspektów i następstw postępujących zmian. Powinnismy wprowadzić prawa ograniczające samowolkę robotów lub ich twórców

Andrzej_Ko

Bardzo fajny artykuł. Przeczytałem z dużą przyjemnością

Norbert Biedrzycki

Bardzo dziękuję

TomaszK1

Ciekawy artykuł. Trochę prowokacyjny 🙂

DCzaj

Najpierw byśmy musieli odpowiedzieć sobie na pytanie czy roboty mają duszę

Krzysztof C

Nie wiem czy zaczną grzeszyć ale już teraz można zgrzeszyć z robotem, wyspecjalizowaną lalką porno. Czy jeśli można z robotem, to pewnie roboty też mogą

Krzysztof Bikowski

„..jest ocena i minimalizacja szkód społecznych we takim zdarzeniu” – a jak by Pan to sobie wyobrażał? Maszyna ocenia czy lepiej dla społeczeństwa jest zbić staruszkę a nie dziecko?

JacekPaczka

Autonomiczne samochody będą ocalały nasze życie, dzięki popełnianiu mniejszej liczby błędów niż ludzie za kierownicą. Czasami jednak staną w obliczu wyboru, czyje życie ratować. Czy należy je zaprogramować, by skręciły i ominęły dziecko przebiegające przez drogę, nawet jeśli narazi to życie pasażerów? A jeżeli trzeba będzie ominąć psa? Co jeśli jedynym ryzykiem jest uszkodzenie samego auta, nie pasażerów?

Norbert Biedrzycki

A może dobym pomysłem jest ocena i minimalizacja szkód społecznych we takim zdarzeniu?

Andrzej44

Nie wierzę w taką wizję. Prędzej do mózgu będziemy podłączaś elektrody. Wtedy wszystko będzie możliwe. Po co nam tylu pośredników jakiś robot albo jakaś skóra jak można będzie zapaść w sen na jawie i tam wszystko przeżywać znacznie intensywniej niż przez skórę. Roboty nie będą etyczne. Trzeba im wbudować jakieś bezpieczniki

Adam T

Bardzo dobry tekst. Aż szkoda że taki krótki

Jacek Czyz

W mojej ocenie każdego dnia będziemy doświadczać coraz większej roli AI w naszym życiu. Dzięki niej możemy liczyć na technologiczne i ekonomiczne korzyści, które jeszcze dzisiaj nie dla wszystkich są jasne, czy oczywiste. Warto zarazem pamiętać że w historii ludzkości każdy przełom technologiczny czy społeczny generował na początkowym etapie kontrowersje, uruchamiał lawinę krytyki i budził sceptycyzm.

Robert Kaczkowski

Nie jestem przekonany czy autonomiczne pojazdy dokonują wyborów samodzielnie. Raczej algorytmy i zaprogramowane przez projektanta procedury i zachowania. Czyli naśladują albo są nauczone na podstawie zachowań ludzi

Jacek B2

Bardzo dobre przedstawinie tematyki moralności maszyn. Ciekawe jak ludzkość ten problem zaadresuje. Interesujący okres przed nami

Norbert Biedrzycki

Bardzo dziękuje. Wydaje się że rozwiązanie prawne to jedyna droga

Grzegorz Wiatr

Poza tym zapomniał Pan o czwartym prawie robotyki Asimowa lub tak zwanym zerowym: Robot nie może skrzywdzić ludzkości, lub poprzez zaniechanie działania doprowadzić do uszczerbku dla ludzkości.

Norbert Biedrzycki

Racja. Dziękuję za zwrócenie uwagi

Grzegorz Wiatr

Elon Musk, który jest jednym z sygnatariuszy listu otwartego wiele razy ostrzegał, iż konieczna jest regulacja w zakresie robotyki. Również Ryan Gariepy, założyciel firmy Clearpath Robotics twierdzi, że „autonomiczne systemy uzbrojenia są obecnie w fazie rozwoju i mają bardzo realny potencjał na wyrządzenie poważnych szkód niewinnym ludziom oraz doprowadzenie do globalnej niestabilności”.

Andrzej_Ko

Śmiercionośne roboty wojskowe mogą w końcu wymknąć się spod kontroli i obrócić przeciwko człowiekowi. Sterowane przez sztuczną inteligencję maszyny mogą rozpocząć zniszczenia, które nie sposób będzie zatrzymać. Raz rozwinięta, śmiertelna, autonomiczna broń pozwoli na walkę zbrojną w skali większej niż kiedykolwiek, może to nastąpić szybciej niż ludzie będą w stanie zrozumieć. Może to być narzędzie terroru, broń, którą despoci i terroryści użyją przeciwko niewinnym ludziom oraz broń która sama zacznie zachowywać się w sposób niepożądany. Nie będziemy musieli długo czekać. Kiedy ta puszka Pandory zostanie otwarta, trudno będzie ją zamknąć.

Norbert Biedrzycki

I znowu ma Pan rację, tak jak w poprzedniej wypowiedzi. Jednak ciągle wydaje mi się że będziemy w stanie nad tym zapanować. Za Stephenem Hawkingiem: ” … If a superior alien civilisation sent us a message saying, „We’ll arrive in a few decades,” would we just reply, „OK, call us when you get here – we’ll leave the lights on”? Probably not – but this is more or less what is happening with AI.

https://genius.com/Stephen-hawking-on-the-threat-of-artificial-intelligence-annotated

TomaszK1

Odwieczne pytanie o świadomość człowieka, nie tylko maszyn, wolną wolę i co ważniejsze konsekwencje decyzji. Bardzo dobry i zarazem trudny temat.

Brawa za odwagę

Norbert Biedrzycki

Dziękuje. Staram się poruszać tematy które są ważna dla nas, na styku maszyny-ludzie

DCzaj

Sam tytuł powoduje u mnie ciary na plecach. Rozumiem że nie chodzi tu o maszyny, drony sterowane np na wojnie ręką człowieka ale o samoświadomość maszyn. 2045 Ray Kurzweil. Bardzo dobry artykuł. Powinnismy mieć o wiele więcej dyskusji w sferze publicznej na tern temat. Wiem że na końcu chciałbym żeby ludzie mogli podejmować kluczowe decyzje, nie roboty. Nawet przeciwko nim

Norbert Biedrzycki

Nie wiem czy 2045, czy 2055. Samoświadomość maszyn nastąpni. Musimy się do tego przygotować. Prawnie i etycznie. Nie mniej ważne są nasze oczekiwania co do maszyn, ich zachowań