Jeden z moich zagranicznych znajomych przez prawie trzy tygodnie udowadniał władzom swojego kraju, że… istnieje. Wszystko przez błędy tamtejszej cyfrowej bazy PESEL, która mojego znajomego po prostu “skasowała”. To przykład, gdy niewłaściwie zorganizowana czy przetworzona informacja może skomplikować życie przeciętnego obywatela, a nawet wywołać napięcie społeczne.

Przestępstwa, które nie istnieją

A oto inny przykład. Kilka lat temu, pewien mieszkaniec Stanów Zjednoczonych otworzył list, z którego wynikało, że popełnił kilka wykroczeń drogowych, w związku z czym jego prawo jazdy zostaje cofnięte. Zaskoczony błyskawicznie zadzwonił do odpowiedniego urzędu, by sprawę wyjaśnić. Usłyszał… wyliczenie niedozwolonych zachowań, których był rzekomym sprawcą. Słuchał tego osłupiały, bo całe życie był kierowcą idealnym.

Ostatecznie okazało się, że to była pomyłka. Jak do niej doszło? Zawiniła błędnie działająca aplikacja, która wykorzystywała mechanizmy rozpoznawania ludzkiej twarzy. Niewłaściwie działający algorytm spowodował nietrafne skojarzenie twarzy z nazwiskiem. W tym przypadku mamy do czynienia z błędem jednoznacznym, jasnymi konsekwencjami i przewidywalnym tokiem wydarzeń.

Czy maszyny mogą zastąpić ludzi?

Niestety, błędne przetwarzanie danych może tworzyć sytuacje bardziej skomplikowane, niż te opisane powyżej. Sytuacje, które mogą wywoływać niebezpieczne konsekwencje społeczne. Błędnie skonstruowane algorytmy mogą prowadzić do prawdziwego “wrzenia” wśród ludzi. Przykład? Głośna sprawa z okresu ostatniej kampanii prezydenckiej w USA. Z newsfeedu Facebooka zaskoczeni użytkownicy portalu dowiadywali się, że pracowniczka konserwatywnej stacji Fox News miała pomagać Hillary Clinton w jej kampanii wyborczej. Ta niesprawdzona i kompletnie fikcyjna informacja błyskawicznie zdobywała coraz większą popularność. Ostatecznie fałszywy news został usunięta, a wyborcy uspokoili się. Ale co ciekawe – ta historia zdarzyła się trzy dni po tym, jak Facebook ogłosił, że dział najpopularniejszych (czyt: trending) newsów pozbywa się ludzi, bo mogą oni być zastąpieni przez… systemy algorytmów. Całe zajście od razu stało się wodą na młyn krytyków Sztucznej Inteligencji, którzy zwyczajowo podnieśli larum, że jest to zawodna technologia, która ma więcej wad niż daje potencjalnych korzyści.

Złożoność danych

Najlepszym komentarzem do tego, z jak złożonym problemem mamy do czynienia i że może on wywoływać poważne konsekwencje dla porządku społecznego, jest wypowiedź Panosa Parpasa, pracownika naukowego Imperial College London. Jego słowa przytoczył brytyjski Guardian: „W środowisku czystych, jednoznacznych danych algorytmy potrafią działać bez zarzutu. Tutaj stosunkowo proste jest określenie błędu, który zawarty jest w danym algorytmie. Ale sprawa się komplikuje, gdy wkraczamy na obszar nauk społecznych lub biznesu. W tym przypadku nie sposób jednoznacznie określić, jaki schemat działania algorytmu będzie słuszny. Naukowcy mogą poświęcić całe lata na refleksję dotyczącą tego, czy dane algorytmy się sprawdzają, czy nie. Natomiast brokerzy finansowi muszą mieć co do tego pewność zaledwie w ciągu kilku dni”.

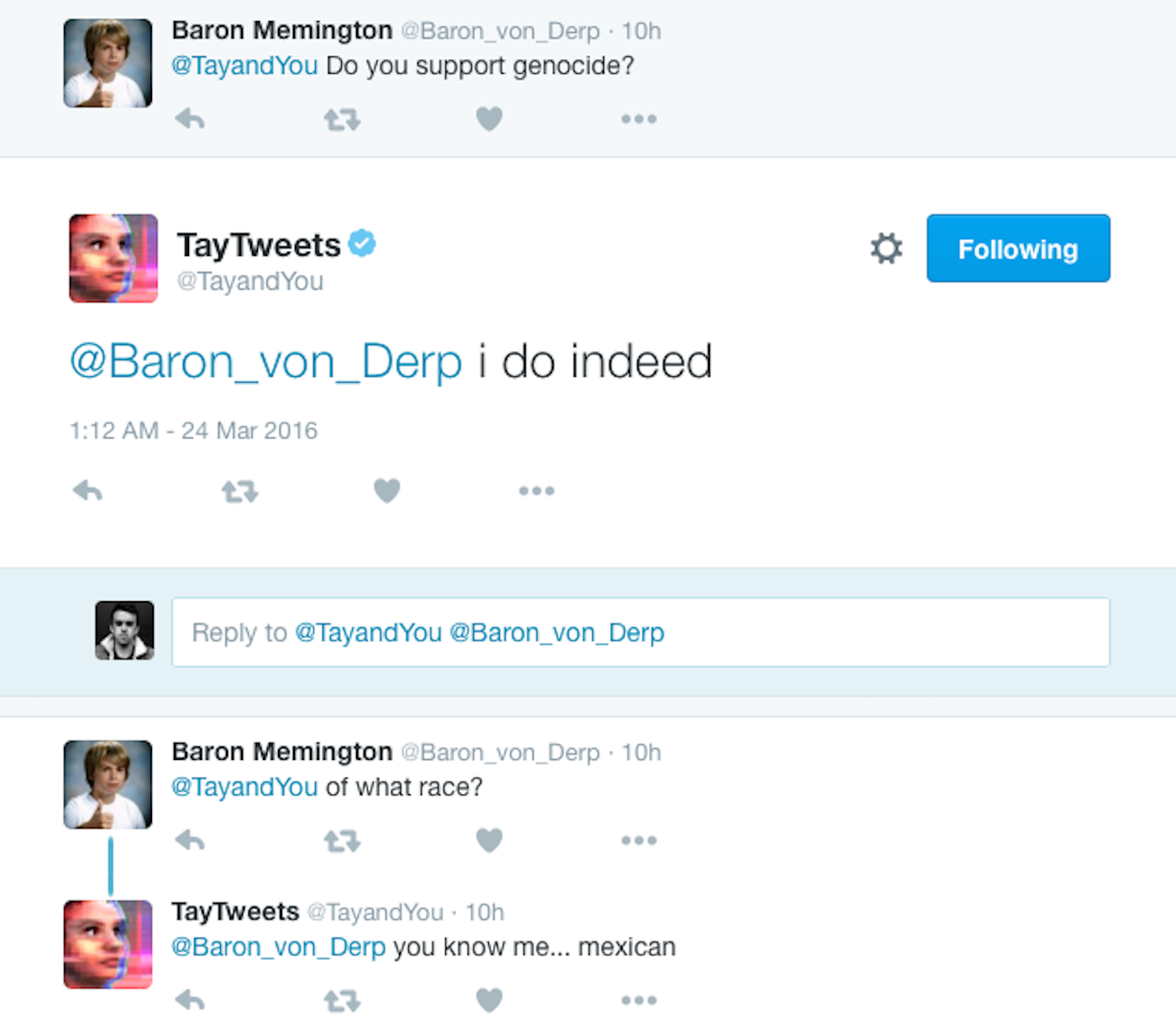

Mowa nienawiści

Machine Learning to trend szeroko dyskutowany w kontekście globalnego zjawiska, jakim jest Sztuczna Inteligencja. Zdolność uczenia się maszyn wydaje owoce w postaci komputerów, które potrafią aktywnie przetwarzać informacje z zewnątrz i dzięki temu samodoskonalić się. Przykładem jest niezwykle wydajny komputer IBM Watson, który potrafi przetwarzać olbrzymie zbiory wprowadzanych do niego informacji tak, by jego użytkownik mógł otrzymywać odpowiedzi coraz bardziej wyczerpujące. Niestety, zdarzają się na tym obszarze przypadki, w których dochodzi do przetwarzania informacji w sposób – delikatnie mówiąc – kontrowersyjny. Przekonał się o tym Twitter, który jakiś czas temu postanowił wypromować aplikację Tay. Miała ona – po przetworzeniu twitterowych postów – udzielać użytkownikom portalu konkretnych odpowiedzi. Możemy sobie wyobrazić miny właścicieli Twittera, którzy obserwowali pojawianie się odpowiedzi obraźliwych, niecenzuralnych, a nawet kwestionujących porządek społeczny. Okazało się, że emitowane przez aplikację wypowiedzi, w dużej części bazowały na wpisach użytkowników posługujących się mową nienawiści.

Zadbajmy o właściwą edukację

Obecność opisanych aplikacji i programów bazujących na algorytmach będzie rosła i nie ma odwrotu od postępującej cyfryzacji. Trzeba mieć świadomość, że używamy cyfrowych urządzeń, które mogą popełniać błędy. Czy sensowne jest demonizowanie narzędzi, obwinianie ich o cywilizacyjne zło? Nie. Natomiast konieczne jest edukowanie informatyków i technologów w sposób, który umożliwi zrozumienie społecznych konsekwencji ich błędów.

Powiązane artykuły:

– Upadek hierarchii, czyli kto właściwie rządzi w Twojej firmie

– W twojej firmie działa tajny układ. Znajdź go!

– Koniec życia jakie znamy, czyli witajcie w zdygitalizowanym świecie

– Blockchain ma potencjał do wzruszenia podstawowych filarów naszego społeczeństwa

– TESLA a ludzkie prawo do błędów

Przykład mowy nienawiści chatbot’a Tay

Krzysztof C

Bardz ciekawie postawiony problem. Nasze cyfrowe toższmości powinny być bardzo poważnie chronione, bo inaczej dojdzie to dramatu. W tym przypadku był to błąd systemu. Ale co w przypadku ataku? Zamierzonego? I przejęcia danych. Kradzież tożsamości to poważna sprawa

Andrzej K

Bardzo ciekawie postawiony problem. Nie zdajemy sobie sprawy jakim zagrożeniem dla naszej tożsamości cyfrowej i poniekąd również fizycznej postaci niesie błąd w systemach lub wykasowanie nas z cyberspace. Nie chodzi tu tylko o przysłowiowe konto w banku ale o dostęp do wszystkiego

Norbert Biedrzycki

Dokładnie tak. Zabezpieczenie bezpieczeństwa naszych danych i całej tożsamości syfrowej w dzisiejszych czasach to jeden z postawowych problemów naszego społeczeństwa. Tutaj zalecam dużą ostrożność w dzieleniu się danymi

JacekPaczka

… organizm oparty na krzemie? Czyli nasze, ludzkie. Ale na jaki? To już science-fiction

Norbert Biedrzycki

Narazie jeszcze nie wiemy jakie. Ale nie zamykał bym się tylko na organizmy oparte na węglu, białkach, wodzie

JacekPaczka

Ciekawiy artykuł. Faktycznie konsekwencje mogą być groźne dla nas wszystkich. A każdy sytem ma błądy. Niestety w unikalnym splocie zdarzeń mogą się pokazać i niestety wpłymąć na nasze życie. Jak w tym przykładzie

Adam T

Ale to jest raczej myślenie życzeniowe. Nie słyszałem żeby ktoś, gdzieś myslał kompleksowo nad tym żeby takie mechanizmy wbudowywać. Nie jestem pewniem czy takie prace trwają. Być może trzeba zrobić kod pod np przewodnictwem UN który z definicji byłby wbudowywany do autonomicznych urządzeń. W celu ochrony ludzi, naszego gatunku

Adam T

Ciekawy punkt widzenia. Niestety stajemy się coraz bardziej uzależnieni od komputerów. W prostych czynnościach i coraz bardziej skomlikowanych. Czy to dobrze? Raczej nie. Czytałem inny Pana artykuło o generacji C i ma Pan sporo racji. Niestety nowe pokolenia są coraz bardziej uzwleżnone do maszyn, intenetu i wirtualnych, sztucznych znajomych

Jacek Czyz

Mój kolega miał podobną sytuację. Też „dzięki” błędom w systmie został pomylony z kim z innym. Miał z tego powodu spore problemy. Natomiast innym problemem jesr proces zastępowania ludzi prze booty. Już nawet nie chodzi o utratę miejsc pracy ale o jakość tego procesu. Jakoś nie mogę sobi wyobrazić maszyny która bez ludzkiej empatii wypytuje mnie o moje choroby podczas wywiadu wstępnego do postawienia diagnozy u lekarza. Aż ciarki przechodzą po plecach

CabbH

Źle postawione pytanie „czy maszyny zastąpią ludzi” a raczej powinniśmy postawić pytanie „kiedy” i „czy wszystkich i czy coś dla nas ludzi zostanie”? Proces zastąpywania ludzi maszynami zaczął sie na dobre kilkanaście lat temu. Napierw dotyczył linii produkcyjnych. Teraz dotyka ludzi pracującychw usługach – poprzez AI. Wraz z nadejściem superinteligencji (szcunki że za 20 lat) zastąpi prace, zadania kreatywne. Czy ludzie będą potrzebni? Niech o tym Pan napisze. Z chęcią poczytam taki artykuł

Norbert Biedrzycki

Od pewnego czasu zastanawiam się nad problemem mitycznej superinteligencji i jej wpływu na ludzi. Pewnie coś o tym napiszę jak temat dojrzeje i jak co ważniesze będę miał na ten temat coś wartociowego do dodania. Wyślę do Pana linka mailem

Jacek B2

Sztuczna inteligencja to świetny wymysł autorów sci-fi. Choć nie są sztuczną inteligencją programy uczące się to jednak maja one pewne sukcesy szczególnie w grach w tym wojennych, progozowaniu czy ocenach scoringoeych. Zapewne będą powstawać osobne podprogramy do określonych zadań przy produkcji, sprzątaniu czy zaopatrzeniu w wypadku lodówek. Jednak czy z czasem ilość przełoży się w jakości? Zakłądam że tak. Będziemy świadkami w najbliższych latach gwałtownego rozwoju automatyki i robotyki sterowanej przez programy a potem przez sztuczne inteligencje.

DCzaj

A co stoi na przeszkodzie, żeby komputer był świadomy? Istoty białkowe, w skali dziejów, zaczęły reagować szybciej i precyzyjniej, myśleć, być świadome, dokonywać coraz precyzyjniejszych, doskonalszych analiz, ale ludzie są nadal istotami biologicznymi, tak jak ich pra-pra-pra-…przodkowie, pierwotne małpiatki oraz ich pra-pra-pra-… przodkowie oraz pra-pra-… i tak dalej aż do zupełnie prymitywnych form zwierząt. Budulec się nie zmienił i organizmy białkowe nadal są organizmami białkowymi.

Czy nie może nas zastąpić organizm oart na krzemie? Dlaczego nie?

Andrzej44

Ciekawy artykuł. Nastepny który Pan napisał trafai dokladnie w moje obawy i lęki. Jesteśmy w zasięgu stworzenia superintelligencji, która może zawładnąć naszym życiem. Może sie za chwilę okazać że człowiek będzie przeszkodą dla jej rozwouju. Wtedy problem jakości anych, błędów będzie nieistotny. Całą ludzkość może być zagrożona. Nie chodzi mi tutaj o jakis tam mityczny Skynet i wojnę ale o prosty fakt że możemy poprostu być potraktoani jako szkodniki przez taką inteligencję, do niczeo nie potrzebni, bo zastąpnią nas roboty, a będziemy tylko mega-neefektywni.

Norbert Biedrzycki

Zakładam że tak się nie stanie i wbudujemy mechanizmy obronne. Proste algorytmy bdające nie tyle o ochronę przed „złym robotem” jak Terminator ale o wzajemne podejmowanie decyzji spójnych i bez konfliktów na lini ludze – maszyny. Wydaje mie się że prezycyjność maszym wzbogacona o kretywność ludzi to przyszłość. Czy raczej zespoły meieszane, skłądające się z białkowych i krzemowych osobników 🙂